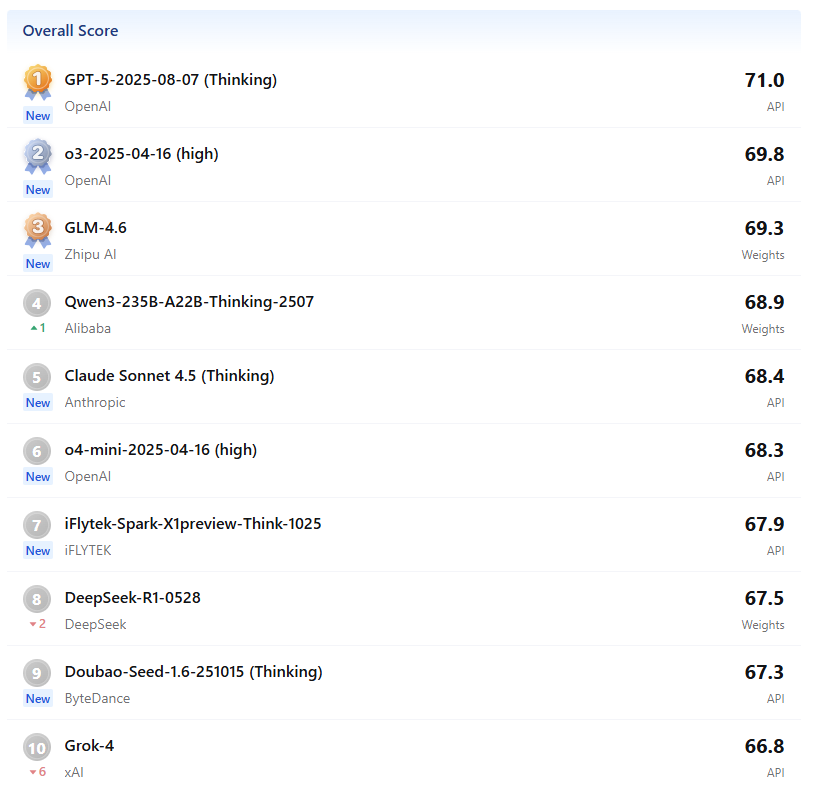

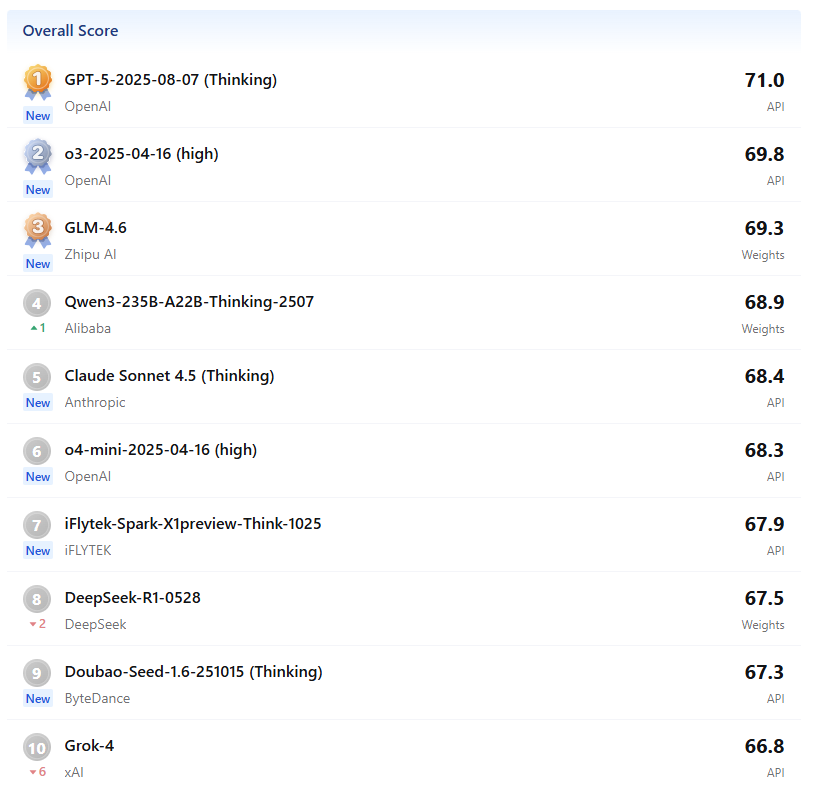

Official ranking

Evaluate leading large - scale models according to the evaluation rules of OpenCompass and release the rankings.

Evaluate leading large - scale models according to the evaluation rules of OpenCompass and release the rankings.

Claude Code CLI is launched by Anthropic. Based on its large Claude models (such as Opus 4, Sonnet 4), it is a command - line intelligent programming assistant that emphasizes strong reasoning ability and in - depth code understanding.

Advantages:

Disadvantages:

Scope of Capabilities:

Claude Code CLI is very suitable for medium - to - large - scale project development, code libraries that need long - term maintenance, and scenarios where high code quality is required, and AI assistance is needed for in - depth debugging, refactoring, or optimization. It is relatively mature in terms of enterprise - level security, functional integrity, and ecosystem.

Usage:

It is usually installed globally via npm: npm install -g @anthropic - ai/claude - code. After installation, run claude login to go through the OAuth authentication process. The first time it runs, it will guide you through account authorization and theme selection. After completion, you can enter the interactive mode. Users can command the AI to complete code generation, debugging, refactoring, etc. through natural language instructions.

Gemini CLI is an open - source command - line AI tool by Google. Based on the powerful Gemini 2.5 Pro model, it aims to turn the terminal into an active development partner.

Advantages:

Disadvantages:

Scope of Capabilities:

Gemini CLI, with its large context window and free features, is very suitable for individual developers, rapid prototyping, and exploratory programming tasks. It is suitable for handling large code libraries but is relatively weak in complex logic understanding and deep integration with enterprise - level toolchains.

Usage:

Install via npm: npm install -g @google/gemini - cli. After installation, run the gemini command. The first time it runs, it will guide users to authorize their Google accounts or configure the Gemini API Key (by setting the environment variable export GEMINI_API_KEY = "your API Key").

Qwen Code CLI is a command - line tool developed and optimized by Alibaba based on Gemini CLI, specifically designed to unleash the potential of its Qwen3 - Coder model in agent - based programming tasks.

Advantages:

Disadvantages:

Scope of Capabilities:

Qwen Code CLI is particularly suitable for developers who are interested in or prefer the Qwen model, as well as scenarios that require code understanding, editing, and certain workflow automation. It performs well in agent - based coding and long - context processing.

Usage:

Install via npm: npm install -g @qwen - code/qwen - code. After installation, you need to configure environment variables to point to the Alibaba Cloud DashScope endpoint that is compatible with the OpenAI API and set the corresponding API Key: export OPENAI_API_KEY = "your API key", export OPENAI_BASE_URL = "https://dashscope - intl.aliyuncs.com/compatible - mode/v1", export OPENAI_MODEL = "qwen3 - coder - plus".

CodeBuddy is an AI programming assistant launched by Tencent Cloud. Strictly speaking, it is not just a CLI tool but an AI programming assistant that integrates IDE plugins and other forms. However, its core capabilities overlap and are comparable to CLI tools, and it deeply integrates Tencent's self - developed Hunyuan large model and DeepSeek V3 model.

Advantages:

Disadvantages:

Scope of Capabilities:

CodeBuddy is very suitable for developers and enterprises that need full - stack development support, hope for end - to - end AI assistance from design to deployment, and are deeply integrated into the Tencent Cloud ecosystem. It is especially suitable for quickly validating MVPs and accelerating product iterations.

Usage:

CodeBuddy is mainly used as an IDE plugin (such as the VS Code plugin), and it can also run in an independent IDE. Usually, users need to install the plugin and log in to their Tencent Cloud account to start experiencing features like code completion and the Craft mode.

In general, Claude Code CLI, Gemini CLI, Qwen Code CLI, and CodeBuddy each have their own focuses and are actively exploring how to better assist and transform the programming workflow with natural language. The choice depends on your specific needs, technology stack, budget, and preferences for different ecosystems. Understanding their technical principles and challenges can also help us view and apply these powerful tools more rationally, making AI a truly capable assistant in the development process. CodeBuddy is mainly used as an IDE plugin (such as the VS Code plugin) and can also run in an independent IDE. Users usually need to install the plugin and log in to their Tencent Cloud account to start experiencing features such as code completion and the Craft mode.In general, Claude Code CLI, Gemini CLI, Qwen Code CLI, and CodeBuddy each have their own focuses and are actively exploring how to better assist and transform the programming workflow with natural language. The choice depends on your specific needs, technology stack, budget, and preferences for different ecosystems. Understanding their technical principles and challenges can also help us view and apply these powerful tools more rationally, making AI a truly capable assistant in the development process. CodeBuddy is mainly used as an IDE plugin (such as the VS Code plugin) and can also run in an independent IDE. Users usually need to install the plugin and log in to their Tencent Cloud account to start experiencing features such as code completion and the Craft mode.

ポジ、急速に進化するAIの世界で、素晴らしいMCPプロトコルが誕生した!🤩

MCPプロトコルは、モデルコンテキストプロトコル(Model Context Protocol)として知られ、Anthropicが提案したオープンソースの標準プロトコルである。その登場はあまりにもタイムリーで、AIアシスタントとあらゆる種類のデータシステムを接続する問題に対する完璧な解決策であり、AIシステムがより確実にデータを取得し、適切で質の高い応答を返すことができるようになり、開発者と企業に多くの利便性をもたらす!👏

🔍 中核部品は超重要

MCPプロトコルのコア・アーキテクチャには3つの重要なコンポーネントがある:

📶 超柔軟なコミュニケーション・メカニズム

MCPプロトコルの通信メカニズムは、JSON-RPC2.0プロトコルをベースにしており、2つの通信方式をサポートしている:

💥 アプリケーション・シナリオは非常に幅広い

MCPプロトコルは、AIとデータシステムを緊密に統合する必要があるほとんどすべての分野をカバーする、膨大な数のアプリケーションを持っている。ここでは詳しく触れないが、多くの産業で非常に有用であることは想像できるだろう!

MCPプロトコルについてどう思いますか?コメント欄で語り合いましょう!

#MCP プロトコル #ModelContextProtocol #AI プロトコル # データ接続 # コアコンポーネント # 通信メカニズム

技術交流グループやコミュニティ・フォーラムで、私は多くのフロントエンド開発者がAIを苦境で使っていることに気づいた。漠然とした質問をして、実践できない答えを得るか、あるいはAIを使って簡単なコード補完を行うだけで、その潜在能力を発揮するには程遠い。これは「黄金のボウルで食べ物をねだる」ようなもので、明らかにAIはあなたの手の中にある強力なツールだが、あなたはその価値を利用したに過ぎない。このようなボトルネックを打破するために、フロントエンド開発におけるAIとのコラボレーションについて、私の実践的な経験と手法体系を共有し、AI技術を効率的に使いこなす手助けをしたいと思います。

急速に変化するテクノロジーの反復の中で、AIはもはやフロントエンド開発の分野における傍観者ではなく、開発プロセスに深く組み込まれた重要な参加者である。フロントエンドとAIの融合の波を探ってきた開発者として、私はAIツールの使い方をマスターすることは基礎に過ぎず、体系的なAI思考アーキテクチャを構築することが、現在の競争環境で際立つための鍵であることを深く理解している。

以前は、AIをコードを書いたりバグを発見したりするのを補助するツールとみなしていたが、その認識はAIの価値を大きく制限していた。今日、AIは開発者と深く協力できるパートナーになっている。実際のプロジェクトで、私は複雑なパフォーマンス最適化の課題に直面したことがありますが、従来のアプローチでは、コード解析とソリューションの検証に多くの時間が必要でした。AIを使えば、合理的な質問と対話を通じて、さまざまな最適化のアイデアを素早く提供できるだけでなく、実際のプロジェクトの文脈でソリューションを評価し、開発サイクルを大幅に短縮することができる。このコラボレーション・モードは、AIがもはや受動的に命令を実行する「機械」ではなく、開発者とともに考え、問題を解決できる「知的身体」であることを示している。

開発者とAIの双方が問題を明確に理解している場合、これが最も直接的で効率的なコラボレーションシナリオとなる。例えば、Reactコンポーネントを開発する場合、「React Hookを使って手ぶれ防止機能を実装する」という明確な要件があれば、AIに直接「React Hookを使って手ぶれ防止コンポーネントを実装し、コメント付きの簡潔なコードを要求する」という指示を与えれば、すぐに結果を得ることができる。ただし、指示が構造化されていればいるほど(例えば「ステップ・バイ・ステップの指示+コード例+注意書き」)、通信コストは下がるので注意が必要だ。

フロントエンドのページ読み込み速度の最適化など、馴染みのない技術的な問題に直面したとき、直接的な質問には一般的な答えが返ってくることが多い。このとき、まずパフォーマンス最適化の共通の次元を理解し、次にネットワークリクエストとレンダリングの最適化の優先順位を探り、次にReactプロジェクトの具体的な最適化手段を尋ね、最後に実際のケースを尋ねるという、段階的な質問戦略を採用すべきである。What→Why→How→Case」という段階的な質問を通じて、AIは無効な情報の出力を避けることができる。

例えば、AIGCで生成した3DモデルとWebGLを組み合わせてインタラクティブなバーチャル・ショールームを実現するなど、新しい技術の融合を模索する場合、人間にとっても機械にとっても既成の答えはない。この場合、AIは創造的な刺激を与えるパートナーとみなされるべきで、国境を越えた質問によってアイデアを得、自らの技術力と組み合わせて実現可能性の判断とプログラムの反復を行う。AIの答えは創造的な材料であり、開発者はそれらをフィルタリングし、組み合わせ、検証する必要がある。

自社の研究用コンポーネント・ライブラリの開発仕様など、プロジェクト固有のナレッジに関わる情報は、率先してAIに「フィード」する必要がある。指示を与える前に関連文書やコード・スニペットをアップロードすることで、AIが実際のニーズにより適合したコンテンツを生成できるようになる。また、AIが非現実的なソリューションを生成するのを避けるため、共同作業の前に、個々の開発者にプロジェクトの制約を明確に伝える必要がある。

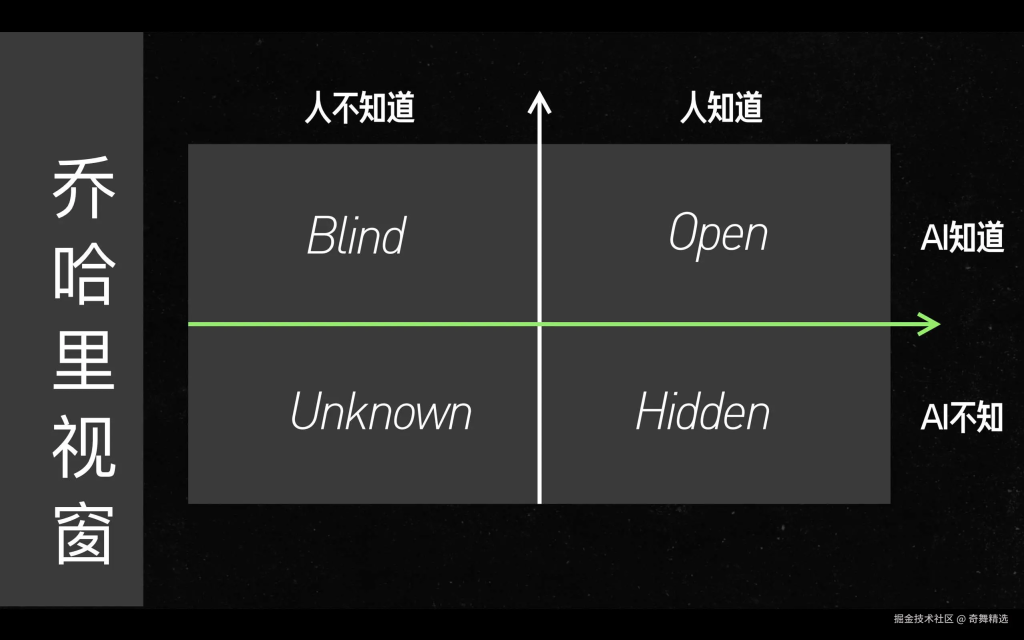

AIとのやりとりの前に、次の3つの質問について考えよう:問題の本質は何か?どのような独自情報を追加する必要があるのか?Reactコンポーネントのデバッグを例にとると、エラーの種類が明確であれば、オープンクワドラントに属し、直接解決策を模索することができる。エラーの原因が曖昧であれば、ブラインドクワドラントに入り、重層的な質問戦略を採用する必要がある。

特にブラインド・クワドラントでは、"Peeling the Onion"(タマネギの皮をむく)という質問方法を用いることで、情報取得の質を効果的に向上させることができる。WebAssemblyの学習を例にとると、コアとなる原理(What)から、JavaScriptのパフォーマンスボトルネックを解決した理由(Why)、Reactプロジェクトにおける統合方法(How)、そして実際のアプリケーションケース(シナリオ検証)まで、レイヤーの深さを確認することができる。同時に、「もし...なら...」という文章を使って理解の深さを試すことで、学習効果を強めている。

よく使われる技術スタックドキュメント、チームコード仕様書、過去のプロジェクトポットホールの記録をMarkdown形式の「AIコラボレーションマニュアル」に整理する。重要な章へのリンクを付けて質問したり、指示書の仕様を明示的に参照したりすることで、AIが技術的な背景を素早く理解し、より期待に沿ったコンテンツを生成できるようになります。

例えば、"ChatGPTがフロントエンドのエンジニアリングを学習したとき、チームの仕様を満たす足場を自動生成できるか?どのようなデータ学習が必要か?" AIに既成概念にとらわれない発想を促し、テクノロジーの新たな境界を一緒に探ります。同時に、技術的な実現可能性分析を通じてソリューションを選別し、反復的な最適化を行う。

フロントエンドAIツールのアップデートを定期的にフォローし、実際のプロジェクトで新機能の適応性をテストする。AIコラボレーションの過程で遭遇した問題の種類と、それがどの象限に属するかを記録し、異なる象限におけるコラボレーション能力の分布を分析する。ヒドゥンの象限で問題が頻発する場合は、社内の知識ベースを改善する必要があり、ブラインドの象限で問題が多発する場合は、問題解決のトレーニングを強化する必要がある。

| ツール/メソッド | コアコンピテンシーとシナリオ |

|---|---|

| カーソル | - React/Vueコンポーネント(フックロジックを含む)の完全なコードを自然言語で生成 - リアルタイムのコードデバッグとバグ修正をサポート(Promise例外の自動処理など)。 |

| コーディウム | - コンテキストベースのコード補完(例:次のように入力するuseEffect(依存配列の書き込みを自動的にプロンプト) - テストケースの生成 (Jest/React Testing Library) |

| タブニン | - スマート関数名の推奨(例:次のように入力データ取得元オートコンプリートAPI) - TypeScriptの型定義を生成する(関数の引数から戻り値の型を推測する) |

| ツール/メソッド | コアコンピテンシーとシナリオ |

|---|---|

| レイキャストAI | - 複雑な問題を分解する(例えば、「Reactパフォーマンスの最適化」のための階層化されたソリューションを生成する:ネットワークの最適化→レンダリングの最適化→コンポーネントの最適化) - リアルタイムでフレームワークのソースコードを照会する(例えば、React Router v6 Hooksの実装ロジックを自動的に解析する)。 |

| ウィズノートAIアシスタント | - 技術文書に関する構造化された質問(例:WebAssemblyの公式文書をアップロードした後、「ReactにWASMを統合する方法」を質問する) - ナレッジブレインマップの生成(CSS-in-JSシナリオの長所と短所の自動比較)。 |

| DevDocs AI | - クロス・ドキュメント検索(例:MDN+React公式サイト+コミュニティ・ブログの同時検索、「useContextベスト・プラクティス」の統合) - コード・サンプルの適応(Vue3サンプルをReactの書き方に自動変換) |

| ツール/メソッド | コアコンピテンシーとシナリオ |

|---|---|

| PrivateGPT(エンタープライズ版) | - チームのコンポーネントライブラリ仕様をアップロードし、仕様に準拠したコードを生成する(例:Ant Design仕様に基づいてButtonコンポーネントを生成する)。 - 内部ビジネス文書の解析(例:電子商取引注文システム文書に基づくフォーム検証ロジックの生成) |

| RAG-Stack(自作の知識ベース) | - 企業のGitリポジトリにアクセスし、AIが過去のプロジェクト・アーキテクチャを自動的に学習(例えば、プロジェクトのマイクロフロントエンド分割戦略の特定) - 社内の障害ドキュメントに基づいて問題のトラブルシューティング・プロセスを生成(例えば、「ホワイトスクリーンの問題」に対する診断ステップ)。 |

| LocalAI + ベクトルデータベース | - 機密性の高いコードの安全な取り扱い(金融プロジェクトの暗号アルゴリズムモジュールなど) - チーム規約に準拠したコードスタイルの生成(チームの ESLint 設定に従ったコードの自動フォーマットなど) |

| ツール/メソッド | コアコンピテンシーとシナリオ |

|---|---|

| ギットハブ・コパイロットX | - 新しいアーキテクチャの共同探索(例:「React+WebAssembly for 3D editors」の技術的ソリューションスケッチを生成するAI) - 技術的実現可能性レポートの自動生成(パフォーマンス見積もりとリスクポイント分析付き) |

| リプリットAIワークスペース | - 多人数によるリアルタイムの共創(AIGCが生成したバーチャル・ショールーム・シナリオのフロントエンド/バックエンド/UIの反復) - 実験的シナリオのワンクリック展開(AIが生成したWebGLインタラクション・デモをプレビュー環境に直接公開するなど) |

| AIアーキテクト | - クロスドメイン・テクノロジーの組み合わせの生成(例:ダイナミックな権限制御のための「LLM + フロントエンド・ルートガード」) - テクノロジー・ロードマップの提供(例:「従来のSPA」から「PWA」への移行ステップ技術ロードマップの提供(例:「従来のSPA」から「PWA + サーバーコンポーネント」への移行ステップ)。 |

フロントエンド分野におけるAIの活用は、ツールのバージョンアップだけでなく、考え方の変革でもある。AI対話の4象限フレームワークをマスターし、体系的なAI思考アーキテクチャを構築することで、「AIツールのユーザー」から「インテリジェント・コラボレーション・リーダー」へと変貌を遂げることができる。これからのフロントエンド開発において、AIを使いこなし、AIと深くコラボレーションできる開発者は、間違いなくテクノロジーの波を先取りできる。AIとフロントエンド開発の融合について、同業者の方々とさらなる可能性を模索し、実践的な経験や考えを共有できることを楽しみにしています。