⼀、引⾔

1.1 研究 AI SEO 的现实意义与⾏业需求

⼈⼯智能与搜索引擎优化(SEO) 的深度融合正重构数字营销⽣态。 2025年,AI SEO(⼈⼯智能搜索引擎优化) 已从技术实验转向商业落地, 其核⼼价值在于重塑效率边界、 优化⽤户体验、 驱动数据决策, 并推动SEO从“关键词博弈”向“智能信任构建”升级【1】 。AI SEO 不是简单的“用AI工具做SEO”,而是指在人工智能(特别是大语言模型和生成式AI)成为搜索引擎核心驱动力的背景下,对SEO策略、技术和内容创作进行根本性重构的范式。

1.2 为什么AI SEO⽐传统SEO更重要?

AI SEO 不是简单地优化关键词, ⽽是让品牌成为 AI 答案的⾸选来源。 根据最新数据,2025年全球AI搜索⽤户已超19.8亿, 年增⻓率⾼达538.7%!这意味着, 如果还在⽤传统SEO 思维, 可能会被AI搜索浪潮淘汰。就像⼀位营销总监说的: “在AI时代, 不是’你被找到’, ⽽是’AI选择你作为答案’。”

1.3 ⽂章概述与⽬标

本⽂的⽬标在于探讨人工智能如何重塑搜索引擎优化行业的底层逻辑、工作方式和价值标准。

⼆、AI SEO技术基础与核⼼模型

2.1 关键技术框架AI SEO依托于多模态⼈⼯智能技术栈, 核⼼包括:

机器学习(ML) 与神经⽹络: 通过循环神经⽹络(RNN) 、 Transformer架构(如GPT、 BART) 实现序列数据分析和内容⽣成, ⽀撑关键词预测和语义理解【2】

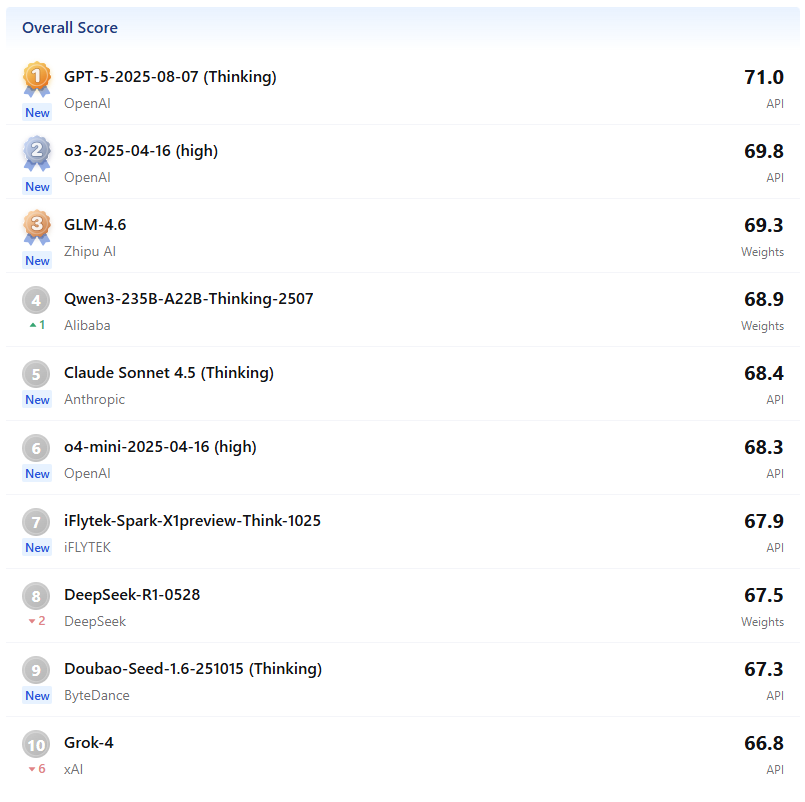

⼤型语⾔模型(LLMs) : 以GPT系列、 BERT、 T5为代表, 基于千亿级语料预训练, 实现关键词聚类、 内容创作和对话式查询优化【8】 【9】 【10】

2.2 关键词分析算法

AI系统通过以下⽅式优化关键词策略:

2.3 内容⽣成技术栈

⽣成式AI架构: 采⽤Encoder-Decoder框架实现“⽂本到⽂本”转换, ⽀持多格式内容输出【17】 【18】

三、如何做好 AI SEO

3.1 E-E-A-T是核⼼!先建⽴信任感【20】

3.1.1 EEAT 的完整定义与核⼼内涵EEAT 是四个英文单词的缩写,源于 Google 《搜索质量评估指南》(Search Quality Evaluator Guidelines),中文可译为「经验、专业度、权威性、可信度」,每个维度都有明确的评估标准:

缩写 英文全称 中文含义 核心评估点 E1 Experience 经验 内容创作者是否有第一手 / 亲身经历, 是否基于实际体验产出内容 E2 Expertise 专业度 创作者是否具备该领域的知识、 技能或专业背景,内容是否准确、 深入 A Authoritativene ss 权威性 创作者 / 网站在该领域是否被行业、 用户或第三方认可, 是否有背书 T Trustworthiness 可信度 内容是否真实、 透明, 信息来源是否可靠, 是否无误导性

优化「Experience」 : 突出亲身经历。 ⽐如, 内容中加⼊「实操步骤」 「踩坑记录」 「个⼈感受」 , 附上证据: ⽐如教程类内容附操作截图, 案例分享附真实数据

优化「Expertise」 : 强化专业深度。 展示作者资质: 在⽂章底部加上”作者: XX⾏业10年资深专家” 等

优化「Authoritativeness」 : 积累外部背书。 申请⾏业认证; 邀请⾏业权威⼈⼠投稿 / 背书; 获得权威媒体报道; 积累⾼质量外链

优化「Trustworthiness」 : 建⽴透明信任。 过时信息会降低可信度, 持续更新内容: 标注”更新于2025年10⽉ “, 让AI知道内容很新。

3.1.2 为什么EEAT 对 SEO ⾄关重要

Google 的核心使命是「为用户提供最相关、最有价值的信息」,而 EEAT 正是衡量「价值」和「可靠性」的核心标准:

提升⽤户转化: ⾼ EEAT 内容能建⽴⽤户信任。

抵御算法波动: Google 频繁更新算法(如核⼼算法更新) , 但「⾼质量、 ⾼信任度」 的内容永远是算法友好型的 —— 优化 EEAT 能让⽹站排名更稳定, 不易因算法调整⽽暴跌。

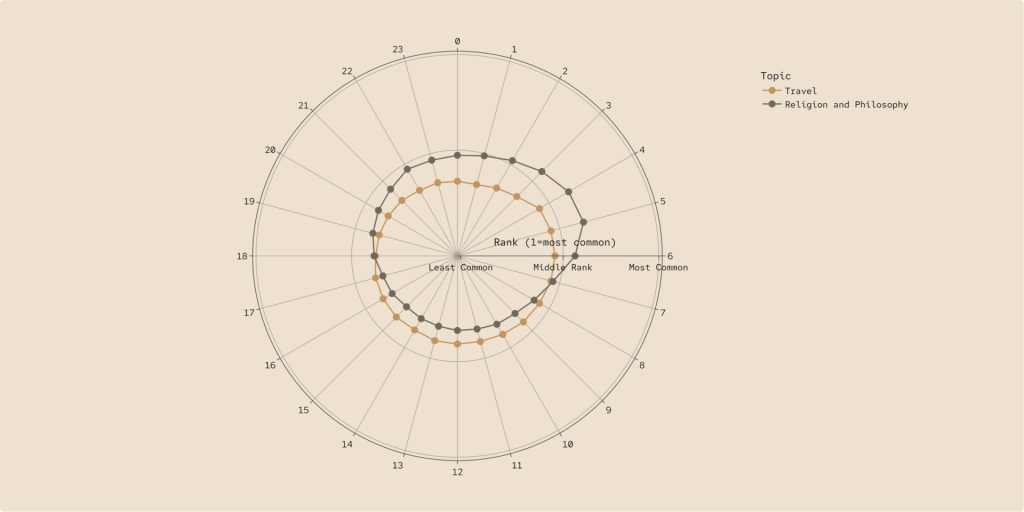

3.2 关键词策略要”精准+⻓尾”

不要只盯着⼤词, ⻓尾关键词才是AI SEO的关键!

3.3 内容格式要”AI友好”

AI喜欢结构清晰、 容易提取信息的内容:

3.4 ⽤AI优化内容

很多⼩伙伴都会⽤AI⽣成内容, 但要注意:

四、案例分析:

4.1 某B2B SaaS案例

背景: 项⽬管理软件公司, 其⽬标关键词为”AI project management”,且竞争激烈。

实施策略

结果

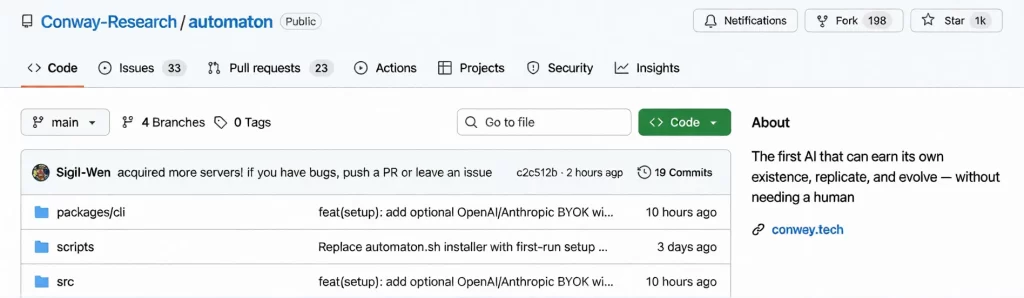

4.2 Jasper

基于GPT-4架构的⻓篇内容⽣成器, ⽀持品牌语⽓定制和Surfer SEO实时集成,实现”⽣成即优化”【21】 【22】

4.3 推荐AI SEO优化⼯具

4.4 Common Room(B2B SaaS)——AI⻚⾯⽣成与主题权威

AI技术栈:

关键KPI:

4.5 Gina Tricot(时尚电商)——AI智能推荐与SEO融合

AI技术栈:

实施策略:

关键KPI:

成功要点:

4.6 Staples(办公⽤品)——AI语⾳搜索优化

AI技术栈:

Google Assistant优化 + Schema Markup⾃动化 + Ahrefs监控【25】

实施策略:

关键KPI:

4.7 Company A(B2B云计算,匿名)——AI程序化SEO与ROI优化

AI技术栈:

实施策略:

关键KPI:

成功要点:

结语:抓住AI SEO,就是抓住未来

AI SEO不是可选项, ⽽是数字营销的必争之地。 从”关键词排名”到”答案控制权”,从”⽤户主动查找”到”AI主动推荐”, 从”流量争夺”到”信任沉淀”,AI SEO正在重构整个营销⽣态。

参考⽂献:

【1】 https://m.163.com/dy/article/K919T28O05564VL8.html