🤖 Claude Code CLI

Claude Code CLI 由 Anthropic 推出,基于其 Claude 大模型(如 Opus 4、Sonnet 4),是一款强调强大推理能力和深度代码理解的命令行智能编程助手。

优点:

- 深度代码理解与复杂任务处理:Claude Code 能深度理解代码库结构和复杂逻辑关系,支持数十万 token 的上下文窗口,能进行高效的多文件联动操作和跨文件上下文理解,尤其擅长处理中大型项目。

- 子代理架构与强大工具集:其支持子代理(sub-agent)架构,能智能地将复杂任务拆分为多个子任务并行处理,实现类多智能体协作。内置工具集丰富且专业,包括更精细的文件操作(如 MultiEdit 批量修改)、高效的文件检索(Grep 工具)、任务管理与规划(TodoWrite/Read,Task 子智能体),以及深厚的 Git/GitHub 集成能力,能理解 PR、审查代码、处理评论等。

- 与企业级工具链集成:Claude Code 不仅能与 IDE 无缝集成,直接在 IDE 的差异视图中展示代码变更,还支持以 GitHub Actions 方式集成到 CI/CD 流程中,允许在 PR 或 Issue 的评论中 @claude 让其自动分析代码或修复错误。

- 精细的权限控制与安全性:提供了一套非常完善和精细的权限控制机制,允许用户通过配置文件或命令行参数精确控制每个工具的权限,例如允许或禁止某个 Bash 命令,限制文件的读写范围,设置不同的权限模式(如 plan 模式只读不写)。在企业环境下,系统管理员还可以强制执行用户无法覆盖的安全策略。

缺点:

- 商业付费产品,订阅费用较高。

- 图像识别能力相对较弱:在处理界面截图的理解分析和设计稿转代码任务时,其精准度和还原度可能不如一些竞品。

能力范围:

Claude Code CLI 非常适合中大型项目开发、需要长期维护的代码库,以及那些对代码质量要求高,需要 AI 辅助进行深度调试、重构或优化的场景。它在企业级安全、功能完整性和生态系统方面较为成熟。

使用方法:

通常通过 npm 进行全局安装:npm install -g @anthropic-ai/claude-code。安装后运行 claude login 进行 OAuth 认证流程。首次运行时会引导进行账户授权和主题选择,完成后即可进入交互模式。用户可以通过自然语言指令指挥 AI 完成代码生成、调试、重构等操作。

🔮 Gemini CLI

Gemini CLI 是 Google 开源的一款命令行 AI 工具,基于强大的 Gemini 2.5 Pro 模型,旨在将终端变为一个主动的开发伙伴。

优点:

- 免费开源与慷慨额度:采用 Apache 2.0 许可证开源,透明度高。个人 Google 账户用户可享受每分钟 60 次请求、每天 1000 次请求的免费额度,这在同类工具中极具竞争力。

- 超长上下文支持:支持高达 100 万 token 的上下文窗口,能轻松处理大规模代码库,甚至一次性读取整个项目,非常适合大型项目。

- 终端原生与强大代理能力:专为命令行界面设计,能最小化开发者的上下文切换。它采用“思考-行动”(ReAct)循环机制,结合内置工具(如文件操作、shell 命令)和模型上下文协议(MCP)服务器,能完成复杂任务如修复错误、创建新功能等。

- 高度可扩展性:通过 MCP 服务器和捆绑扩展,以及 GEMINI.md 文件进行自定义提示和指令,具有很高的可定制性。

缺点:

- 指令执行与意图理解的精准度有时不如 Claude Code,表现稍逊色。

- 免费版存在数据安全隐患,用户数据可能被用于模型训练,不适合处理敏感或专有代码。

- 输出质量可能存在波动,用户反馈显示 Gemini-2.5-pro 有时会自动降级为性能较弱的 Gemini-2.5-flash 模型,导致输出质量下降。

- 与企业级开发环境的集成相对薄弱,更多被定位为一个独立的终端工具。

能力范围:

Gemini CLI 凭借其超大上下文窗口和免费特性,非常适合个人开发者、快速原型构建以及探索性编程任务。它适合处理大型代码库,但在复杂逻辑理解和与企业级工具链的深度集成上相对较弱。

使用方法:

通过 npm 安装:npm install -g @google/gemini-cli。安装后运行 gemini 命令,首次运行会引导用户进行 Google 账户授权或配置 Gemini API Key(通过环境变量 export GEMINI_API_KEY=”你的API Key”)。

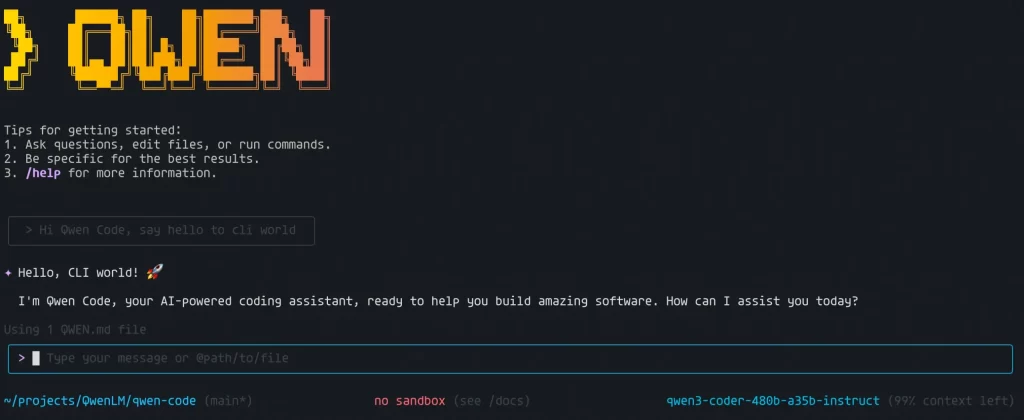

🌐 Qwen Code CLI

Qwen Code CLI 是阿里巴巴基于 Gemini CLI 二次开发优化的命令行工具,专门用于激发其 Qwen3-Coder 模型在智能体编程任务上的潜力。

优点:

- 针对 Qwen3-Coder 深度优化:为 Qwen3-Coder 系列模型(如 qwen3-coder-plus)定制了提示词和函数调用协议,能最大程度激发其在 Agentic Coding 任务上的表现。

- 支持超长上下文:依托 Qwen3-Coder 模型原生支持 256K token,并可扩展至 100 万 token,适合处理中大型项目。

- 开源且支持 OpenAI SDK 格式:方便开发者通过兼容的 API 调用模型。

- 广泛的编程语言支持:模型原生支持多达 358 种编程和标记语言。

缺点:

- Token 消耗可能较快,尤其使用大参数模型(如 480B)时成本较高,需密切关注使用量。

- 对复杂任务的理解和执行可能有时会陷入循环或表现不如顶级模型。

- 工具调用的理解精度有时可能存在偏差。

能力范围:

Qwen Code CLI 尤其适合关注或偏好 Qwen 模型的开发者,以及需要进行代码理解、编辑和一定工作流自动化的场景。它在代理编码、长上下文处理等方面表现不俗。

使用方法:

通过 npm 安装:npm install -g @qwen-code/qwen-code。安装后需要配置环境变量指向兼容 OpenAI API 的阿里云 DashScope 端点,并设置相应的 API Key:export OPENAI_API_KEY=”你的API密钥”、export OPENAI_BASE_URL=”https://dashscope-intl.aliyuncs.com/compatible-mode/v1″、export OPENAI_MODEL=”qwen3-coder-plus”。

🚀 CodeBuddy

CodeBuddy 是腾讯云推出的 AI 编程助手,严格来说它不仅仅是一个 CLI 工具,而是一个集成了 IDE 插件等多种形式的AI编程助手,但其核心能力与 CLI 工具有很多重叠和可比性,并且深度融合了腾讯自研的混元大模型和 DeepSeek V3 模型。

优点:

- 产设研一体化:集成了需求文档生成、设计稿转代码(如 Figma 转生产级代码,还原度高达99.9%)及云端部署功能,实现从产品设计到研发部署的全流程 AI 一体化开发。

- 本土化优化与腾讯生态集成:专为中国开发者优化,提供更好的中文支持,并深度集成腾讯云服务(如 CloudBase),支持一键部署。

- 双模型驱动:集成腾讯混元大模型和DeepSeek V3 模型,提供高精度的代码建议。

- 可视化体验:提供 Webview 功能,可在 IDE 内直接预览代码调试成果,交互体验流畅。

缺点:

- 部分功能交互(如 @ 符号交互)可能需要进一步简化以提升操作便捷性。

- 在大项目中代码扫描速度可能较慢。

- 与 VSCode 等编辑器的插件兼容性仍有待增强。

- 目前使用 可能需要邀请码 。

能力范围:

CodeBuddy 非常适合需要全栈开发支持、希望从设计到部署全流程AI辅助、以及深度融入腾讯云生态的开发者与企业。它尤其适合快速验证 MVP、加速产品迭代。

使用方法:

CodeBuddy 主要作为 IDE 插件(如 VS Code 插件)使用,也可以在独立 IDE 中运行。用户通常需要安装插件并登录腾讯云账号即可开始体验其代码补全、Craft 模式等功能。

总而言之,Claude Code CLI、Gemini CLI、Qwen Code CLI 和 CodeBuddy 各有侧重,都在积极探索如何用自然语言更好地辅助和变革编程工作流。选择哪一款,取决于你的具体需求、技术栈、预算以及对不同生态的偏好。理解它们的技术原理和面临的挑战,也能帮助我们更理性地看待和应用这些强大的工具,让 AI 真正成为开发过程中的得力助手。CodeBuddy 主要作为 IDE 插件(如 VS Code 插件)使用,也可以在独立 IDE 中运行。用户通常需要安装插件并登录腾讯云账号即可开始体验其代码补全、Craft 模式等功能。

发表回复